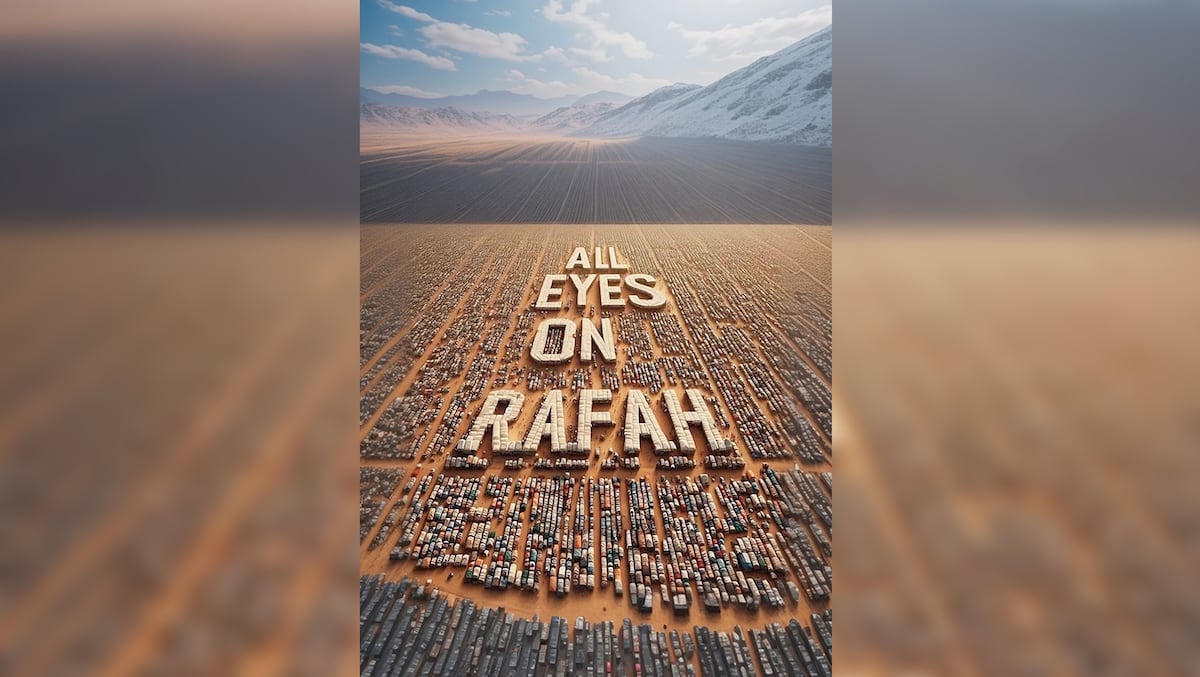

A medida que avanzamos hacia un futuro digital, estamos confrontados con una serie de dilemas y desafíos. Uno de ellos es el uso creciente de la inteligencia artificial (IA) en nuestras vidas cotidianas. Recientemente, una imagen generada por IA en Instagram, con el lema «All eyes on Rafah» se viralizó, generando una ola de indignación contra el asesinato de niños en Gaza. Con 33 millones de veces compartida en 24 horas, esta imagen se convirtió en un potente vehículo para expresar la indignación global.

La imagen fue creada por un joven que utilizó las banderas de Malasia e Indonesia en su perfil de Instagram: @chaa.my_. A pesar de que tenía pocos seguidores antes de que su imagen se viralizara, el joven utilizó la herramienta de creación de imágenes sintéticas para diseñar la imagen que finalmente logró captar la atención del mundo. Entre los millones que compartieron la imagen se encuentran personalidades como la ganadora del Premio Nobel de la Paz, Malala Yousafzai, la vicepresidenta Yolanda Díaz, el futbolista Dembelé, la exprimera ministra finlandesa Sanna Marin y la actriz Bella Hadid.

Estos ejemplos nos muestran cómo la psicología humana puede ser un catalizador potente para la viralización de un meme. No sólo se comparte la desinformación más que la noticia veraz, sino que también podemos ser persuadidos para retuitear o compartir contenido, independientemente de su autenticidad.

El surgimiento de los deepfakes ha generado preocupación en cuanto a su potencial para distorsionar la realidad. Sin embargo, el uso de una imagen sintética como la de Rafah demuestra que la inteligencia artificial puede ser utilizada de manera efectiva para expresar indignación y resistencia.

Este fenómeno coincide con el anuncio de Mark Zuckerberg de que Facebook e Instagram utilizarán los contenidos compartidos por los usuarios para alimentar su inteligencia artificial, a menos que se indique lo contrario. Esta práctica plantea una serie de dilemas éticos, ya que las grandes empresas tecnológicas necesitan constantemente información para entrenar sus modelos de inteligencia artificial. Sin embargo, si se utilizan imágenes generadas por máquinas para entrenar estos modelos, corremos el riesgo de entrar en un ciclo de retroalimentación donde la calidad de la información se deteriora.

El término enshittification, acuñado por Cory Doctorow, describe este proceso de degradación de la calidad de la información en la red. Las plataformas, en su afán por satisfacer a los usuarios, pueden acabar generando resultados indeseables. Google es un ejemplo de esto: durante 25 años nos ha convencido de la eficiencia de su buscador, pero ahora parece que las consultas devuelven cualquier cosa menos un link interesante a donde hacer clic.

El desarrollo de la inteligencia artificial también ha sido objeto de debate. Hace algo más de un año, algunos de los actores más relevantes del universo tecnológico pedían una moratoria de seis meses en su desarrollo debido a las posibles catástrofes que podría causar. Sin embargo, 14 meses después, las máquinas no han mejorado exponencialmente sus capacidades y la empresa que lideró la revolución, OpenAI ha sufrido una serie de crisis reputacionales. Mientras tanto, Elon Musk ha recaudado más de 5.500 millones de euros para su propia empresa de inteligencia artificial, xAI.

Estos acontecimientos nos llevan a reflexionar sobre el futuro de la inteligencia artificial y la ética que debería regir su desarrollo y uso. Como sociedad, debemos preguntarnos si seremos capaces de frenar este ciclo de degradación de la calidad de la información y cómo podemos garantizar un uso responsable de la inteligencia artificial que respete los derechos humanos y la integridad de la información.