El mundo de la conducción autónoma está entrando en una nueva fase de evolución, según informa la revista científica Nature. La clave para el avance de esta tecnología radica en la habilidad para ver, analizar, discriminar y actuar en milisegundos, una característica humana que los ingenieros están tratando de replicar en las máquinas. Para los vehículos autónomos, el desafío consiste en discernir si un objeto es estático o móvil y tomar una decisión instantánea basada en esa información.

La última edición de Nature presenta dos descubrimientos significativos en este campo: un procesador diseñado para responder a un evento con la mínima información y un nuevo sistema (algoritmo) diseñado para mejorar la precisión de la visión mecánica con menor latencia, o tiempo de respuesta. Estas investigaciones son esenciales para el desarrollo de los vehículos de conducción autónoma y la robótica.

Las investigaciones se han llevado a cabo en el Instituto de Microelectrónica (Imse) en la capital de Andalucía, del Consejo Superior de Investigaciones Científicas (CSIC) y la Universidad de Sevilla. Empresas multinacionales como Samsung y Sony ya están utilizando las patentes que comercializa la empresa Prophesee.

Los nuevos sistemas se basan en la foveación, un mecanismo humano que maximiza la resolución en la zona donde se enfoca la vista, mientras que disminuye la resolución en las áreas de visión periférica no relevante. Este mecanismo también ayuda a reducir la cantidad de información que se necesita, pero sigue manteniendo la capacidad de reconocimiento visual necesaria para tomar decisiones rápidas.

Las cámaras convencionales pueden captar imágenes de alta resolución, pero el procesamiento y discriminación de toda esa información requiere tiempo y recursos, lo cual es incompatible con las decisiones instantáneas necesarias en la conducción autónoma y la robótica avanzada.

El primer avance ha sido realizado por Daniel Gehrig, investigador de la Universidad de Pensilvania (EE UU), y Davide Scaramuzza, profesor de robótica en la Universidad de Zúrich (Suiza). Han abordado el problema de la toma de decisiones con imágenes de alta resolución en color que requieren un gran ancho de banda para ser procesadas. La alternativa que proponen es el uso de una cámara de eventos, que procesa flujos continuos de impulsos, a costa de sacrificar precisión.

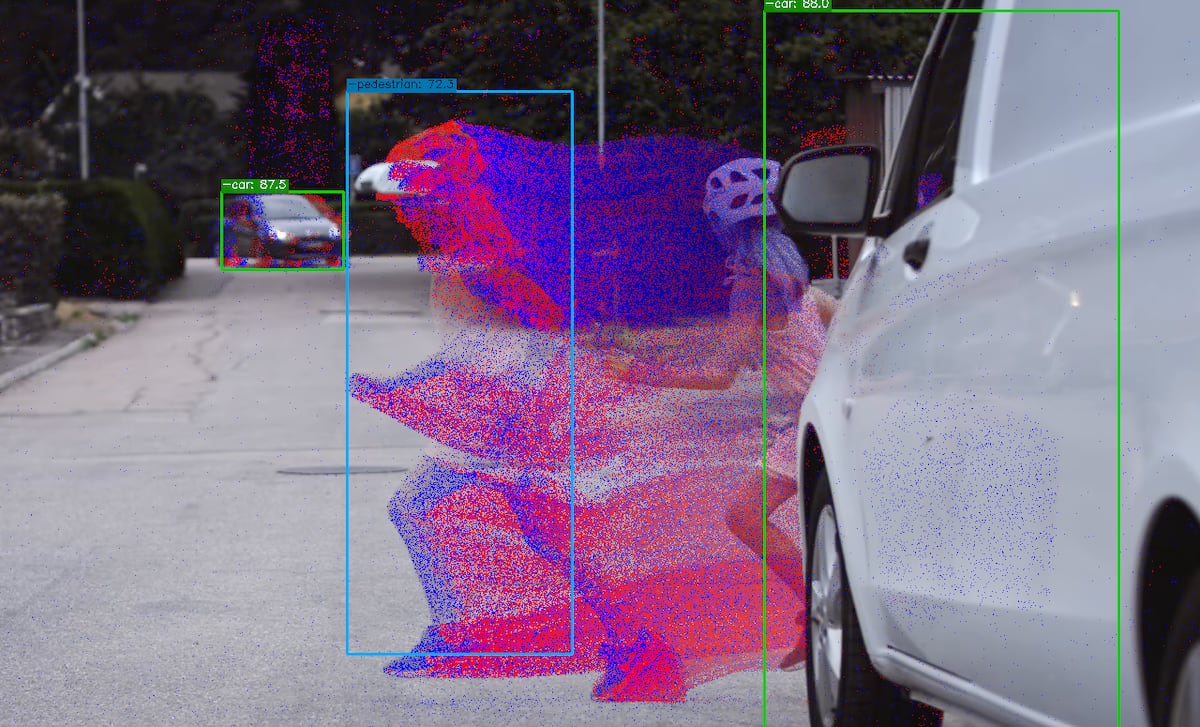

Para superar estos desafíos, los investigadores han desarrollado un sistema híbrido que logra la detección eficaz de objetos con la mínima latencia. Este sistema combina la información de dos cámaras: una que reduce la velocidad de los fotogramas en color para reducir el ancho de banda necesario, y otra de eventos que compensa la pérdida de latencia. Los investigadores afirman que los resultados «allanan el camino hacia la detección eficiente y precisa de objetos, especialmente en escenarios extremos».

Por otro lado, Luping Shi, director del Centro de Investigación de Computación Inspirada en el Cerebro (CBICR por sus siglas en inglés) de la Universidad de Tsinghua (China), ha desarrollado con su equipo el chip (procesador) Tianmouc. Este chip se inspira en el sistema visual humano y combina percepciones rápidas e imprecisas con otras de mayor resolución y más lentas para procesarlas.

El chip trabaja como una cámara de eventos, que en lugar de fotogramas completos, procesa flujos continuos de impulsos eléctricos registrados por cada fotosensor cuando detecta un cambio suficiente de luz. El chip Tianmouc ha sido probado con éxito en escenarios como un túnel oscuro iluminado repentinamente por una luz deslumbrante o una carretera por la que cruza un peatón.

Bernabé Linares, profesor de investigación del Imse y responsable de la cámara de eventos comercial de mayor resolución, resalta que estos avances son importantes para el desarrollo de la conducción autónoma y la robótica. Aunque la conducción autónoma es un foco importante, los avances en visión también tienen un gran impacto en la robótica, especialmente en los procesos de automatización industrial.